はじめに

先週の金曜日の「脳型情報処理機械論」の第5回目の講義については先に投稿した。ただ、2つの論点についての考察や、それを理解するためのキーワードの解説などについて追記したい。

#5-1:神経回路網と脳の確率的力学的理論(先に投稿)

#5-2:脳はどのようにして確率的な活動を生み出しているのか?その計算上の役割は何か?(今回の投稿)

疑問

脳はどのようにして確率的な活動を生み出しているのか?

(How does the brain generate the stochastic activity ?)

その計算上の役割は何か?

(What is the computational roles of this ?)

論点を理解するための基礎知識

応答の信頼性と多様性

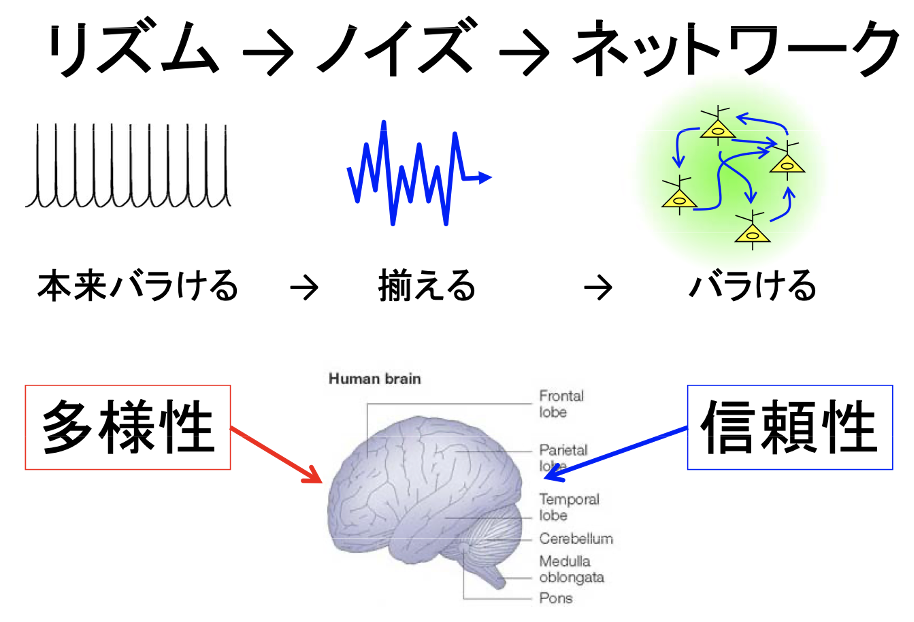

個々の神経細胞は本来はそれぞれがバラけている。しかし、それらが揃えられた後にバラけている。神経細胞の揺らぎを作っているのは、熱揺らぎではない。イオンチャネルの揺らぎでもない。シナプス伝達の失敗でもない。神経ネットワークが揺らぎを作っていると考えられる。

(出典:理研)

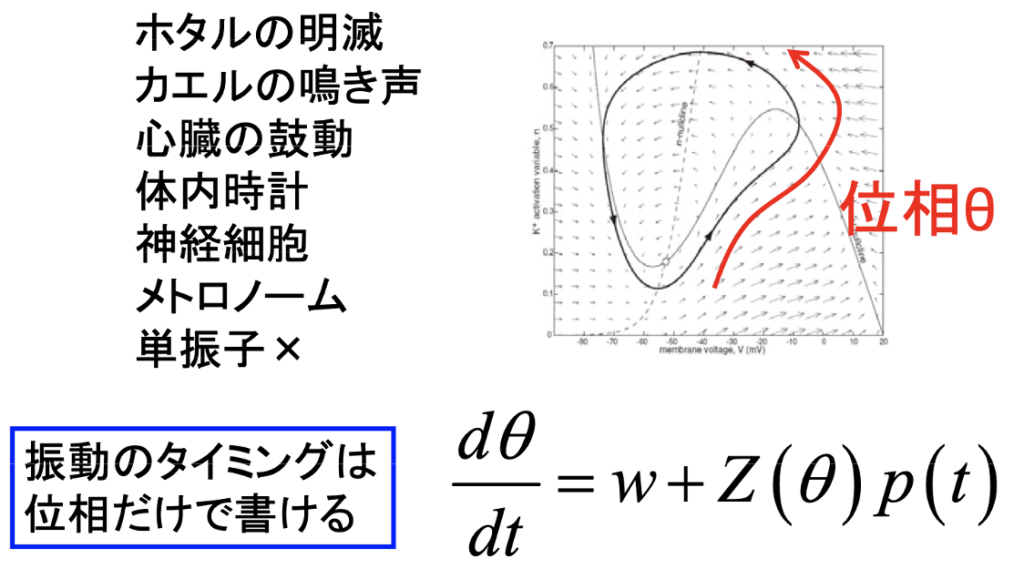

位相とタイミング

神経ネットワークは安定した振動子である。周期的にスパイク発火する。ホタルの明滅やカエルの鳴き声、心臓の鼓動、体内時計どれも安定した振動であり、振動のタイミングは位相を変数とする数式で記述できる。

(出典:理研)

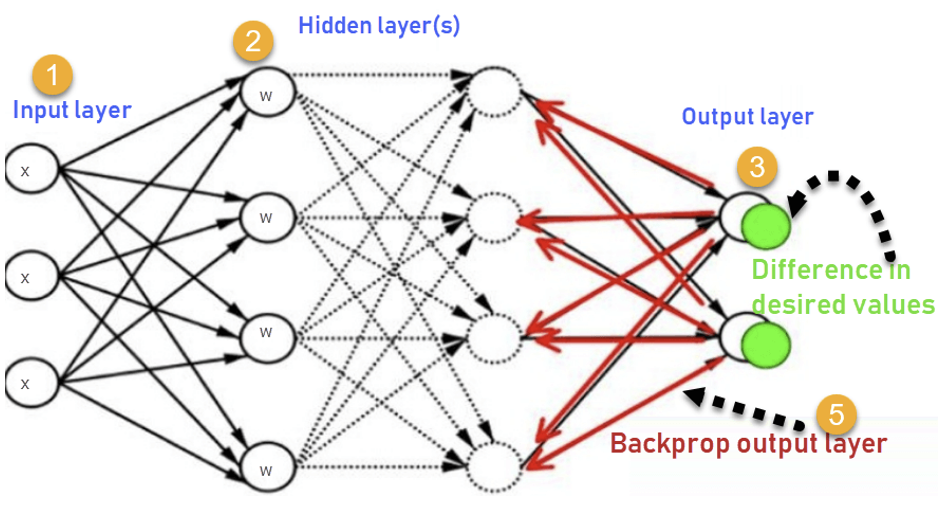

バックプロパゲーション(Back Propagation)

バックプロパゲーション(BP)は、フィードフォワード・ニューラル・ネットワークを学習するためのアルゴリズムとして広く用いられている。BPは,ANN(人工ニューラルネットワーク:artificial neural networks)に対しても一般化されている。BPは、ニューラルネットワークのフィッティングにおいて、1つの入出力例に対するネットワークの重みに対する損失関数の勾配を計算するものである。勾配を個別に直接計算するよりも効率的に計算できる。この効率性により、多層ネットワークの学習に勾配法を用いることが可能となった。一般的に、勾配降下法または確率的勾配降下法などのバリエーションが用いられる。BPアルゴリズムは、各重みに対する損失関数の勾配を連鎖律で計算し、連鎖律の中間項の計算が重複しないように、最後の層から逆に繰り返して勾配を計算するもので、動的計画法の一例である。

(出典:Guru99)

ベイズ型ニューラルネットワーク

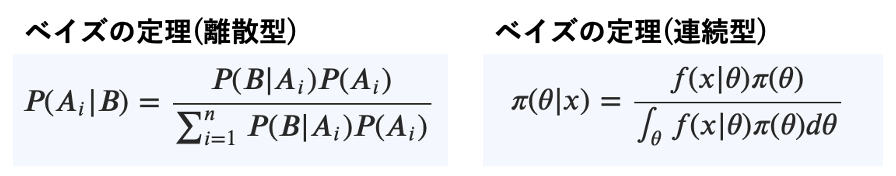

離散型と連続型

ベイズの定理には離散型と連続型がある。

まず前者の離散型では、それぞれの確率を次のように捉える。ベイズの定理を使うことで、新しい情報(B)が得られたときに、既存の事象(Ai)の確率を更新できる。

P(Ai):事前確率

P(Ai|B):事後確率

P(B|Ai):尤度(ゆうど:likelihood)

∑ni=1P(B|Ai)P(Ai):周辺尤度

一方、連続型のベイズの定理では、連続値を想定する。現実世界の変数の多くは連続値である。連続型のベイズの定理では次のように、離散型の記号を読み替える。既知情報A1,A2,…An,はθとなり、パラメータを指す。新規情報はBはxとなり、データを指す。つまり、連続型のベイズの定理は「新しいデータxが与えられた状況で、それまで既知だったパラメータθが取り得る値の分布」を求めている。連続型の場合、π(θ)を事前分布、π(θ|x)を事後分布、f(x|θ)を尤度、∫θf(x|θ)π(θ)dθを周辺尤度と呼ぶ。この「新しいデータで既知の確率・分布を更新する」という考え方が、現在の機械学習の手法と非常に相性が良く、ベイズ統計学が注目され、活用されるようになった。

(出典:京都大学)

ベイズ推定

ベイズ推定は、ベイズの定理を用いて、より多くの証拠や情報が得られたときに仮説の確率を更新する統計的な推定方法である。ベイズ推定は、一連のデータの動的分析において重要である。ベイズ推定は、科学、工学、哲学、医学、スポーツ、法律など幅広い分野で応用されている。ベイズ推定は主観的な確率と密接に関連しており「ベイズ確率」とも呼ぶ。下の図(左)は、ベイズの定理を幾何学的に視覚化したもので、図示された値(2、3、6、9)は、対応する各条件とケースの相対的な重みを示す。下の図(右)各重みに関係する表のセルを示しており、確率は各図の影の部分になる。

これは、P(A|B) P(B) = P(B|A) P(A)すなわち、P(A|B) = P(B|A)P(A)/P(B)となる。

(出典:Bayesian Inference)

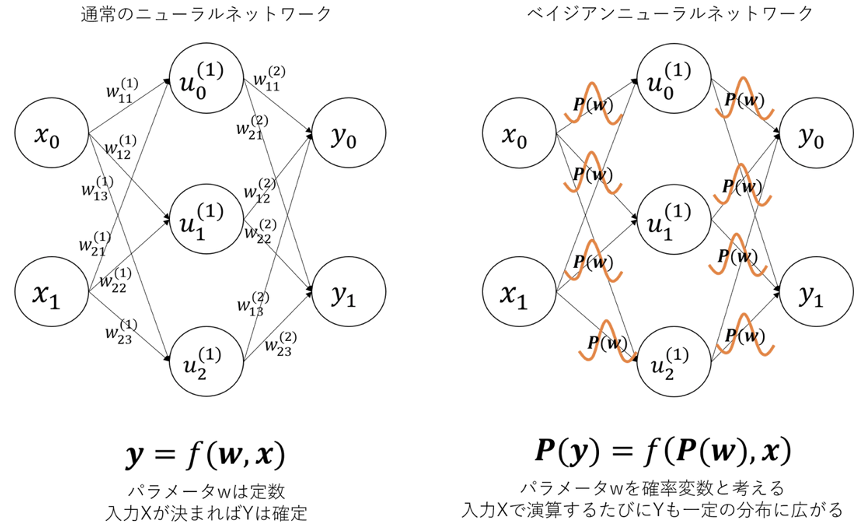

ニューラルネットワーク(NN:Neural Network)

下の図(左)は、通常のNNの模式図を示す。下の図(右)は、ベイジアンNNの模式図を示す。通常のNNでは各層の重みパラメータの値は学習によって収束した定数として扱われます。一方、ベイジアンNNでは、重みパラメータをある確率分布に基づいて生成される確率変数である。ベイジアンNNでは、学習結果を確率変数とみなし、重みパラメータの推定値が従う確率分布があるというアプローチを取る。ベイジアンNNでは、推論時においてモデルに入力が与えられる度に、確率分布P(w)よりサンプリングされた値が重みパラメータに設定されて演算される。これにより、同じ値xをモデルに入力しても毎回異なる値yが出力され、予測値yが一定の分布に広がる。

(出典:Qiita)

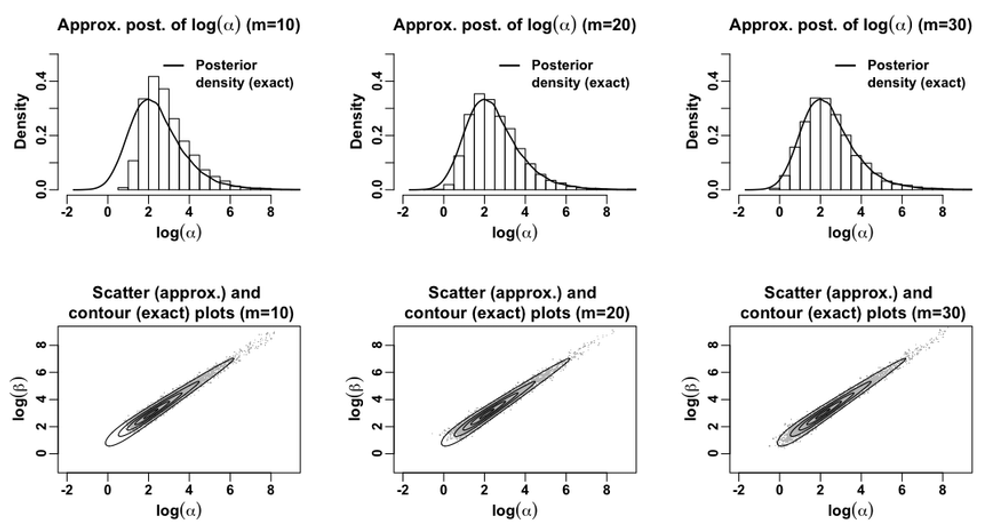

ギブスサンプリング(Gibbs sampling)

ギブスサンプリングは,直接的なサンプリングが困難な場合に,指定された多変量確率分布から近似された観測値のシーケンスを得るためのマルコフ連鎖モンテカルロ(MCMC : Markov chain Monte Carlo)アルゴリズムである。このシーケンスは,ヒストグラムを生成する結合分布の近似や変数の1つまたは変数の一部の周辺分布の近似,または変数の1つの期待値などの計算に使用できる。一般的に,変数のいくつかは,値が既知の観測結果に対応している。ギブスサンプリングは、ベイズ推論の手段として統計的推論に用いられる。ギブスサンプリングは、乱数を利用したランダム化アルゴリズムであり、期待値最大化アルゴリズム(EM : expectation-maximization algorithm)などの統計的推論のための決定論的アルゴリズムの代替として利用される。

(出典:research gate)

ニューロンとシナプスの確率的更新規則

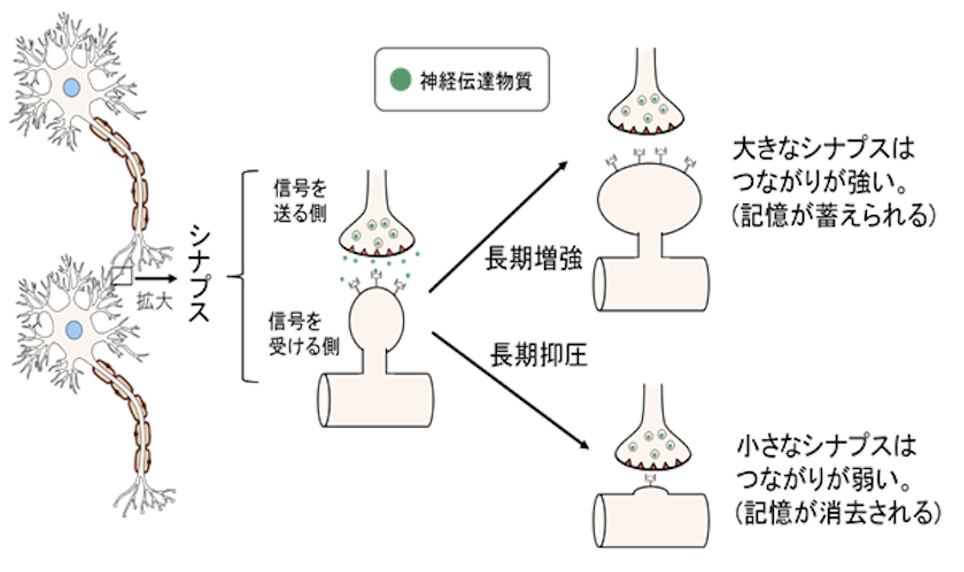

忘却の脳内メカニズム

以前、同僚に忘れることのできない頭脳を持つ人がいた。京都大学の出身だったけど全く使えない。なぜ使えないかというと、過去のオリンピックの選手、歴代大統領の名前、過去に記憶したことは全て正確に再現できるが、新しい情報を記憶することが困難だったからだ。そもそも新しいことにチャレンジする意欲もない。結局、コールセンターのクレーム担当に異動された。新しいことを記憶するには、古い記憶や不要となった記憶を整理=忘却する機能が重要なことを思い知った。脳の処理として忘却する仕組みは、「シナプスの可塑性」が関係している。記憶には、ずっと覚えている記憶と短期で忘れてもいい記憶があります。シナプスの可塑性は、よく使われる記憶を蓄え、使われない記憶を消去して情報を整理するという働きをする。これは素晴らしい仕組みといえる。記憶と忘却により情報の取捨選択が行われる状態が正常な脳の処理状況である。シナプスの可塑性が機能しないと忘却できなくなることに繋がり、心身に影響が生じる懸念がある。

(出典:東洋大学)

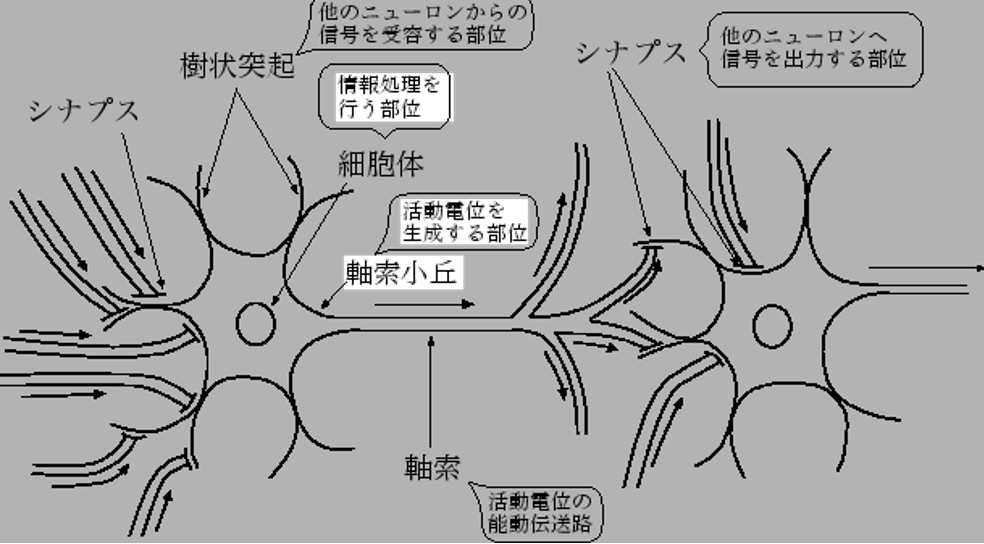

神経細胞の構造

神経細胞(neuron)とは、生物の脳を構成する細胞である。神経細胞は、 核が存在する細胞体、ニューロンの入力である樹状突起、出力部分であるシナプス、 伝送路に当たる軸索から構成する。人間の脳には神経細胞が100億から1000億程度あると言う。神経細胞は立体的に多数集まって回路網を形成する。個々のニューロンは他のニューロンから出力を受けとりシナプスで増減し、 それを足した値がある値を超えると出力し、他の結合されたニューロンに伝送する仕組みだ。ニューロンでは、神経インパルス(Nervous Impulse)と呼ばれる電気パルスを生成する。この神経インパルスは神経細胞間で化学反応を介して行なわれる。 そのパルス幅は、約1msの遅延が生じる。このパルスの出力は入力の合計が閾値より小さいと出力されず、閾値を超えるとパルスを出力する。 出力するパルスの振幅は、入力値に関わらずほぼ一定である。 この特性は、全か無かの法則(all-or-none law)と呼ばれる。

(出典:Deguchi Lab)

疑問への結論

疑問1への結論:大脳皮質は、大量のエネルギーを消費して、不均一なシナプスの分布を利用して、自発的に確率的な活動を生成する。

The cortex spontaneously generates the stochastic activity by using the highly heterogeneous distribution of synapses with consuming large amount of its energy.

疑問2への結論:確率的な神経とシナプスの確率的な神経とシナプスの活動は、相乗的なベイジアンサンプラーとしてサンプラーを用いて、ロバストで信頼性の高い学習・推論を実現学習・推論を行うことができます。最適化することなく、ロバストで信頼性の高い学習・推論を実現することができます。

The stochastic neural and synaptic activity can be a synergistic Bayesian sampler to realize robust and reliable learning and inference without explicit optimization.

まとめ

脳型情報処理機械論の5回目の講義については先に投稿したが、示された2つの論点を理解するための基礎知識が決定的に不足していることを痛感した。特に、ベイズの定理や、ギブスサンプリング、バックプロパゲーションと聞いても、意味が連想できなかったので、基本に立ち返ることで理解を深めるように努めた。個々の神経細胞が発する信号は本来バラバラのはずだけどネットワークを経由することでまとまり、揺らぎに収斂されるという現象は、大量の小鳥が空を飛ぶときの同調性や、小魚が群を成して海を泳ぐときの同調性と共通するような気がして、面白いと思った。

以上

最後まで読んで頂きありがとうございました。

拝