はじめに

磯村博士の講義の概要については、これまでにすでに3回投稿したが、今回で区切りとしたい。

その1:生物脳における知能の数学的理論の概要(初回の投稿)

その2:ニューラルネットワークの基本的事項(前々回の投稿)

その3:変分ベイズの等価性の基本的事項(前回の投稿)

その4:自然淘汰から生まれる知性の基本的事項(今回の投稿)

自然淘汰から生まれる知性の基本的事項

(Inteligence emerging from natural selection)

知性、意識、心、感情。これらはどこから来ているのか?それぞれは密接に関係しているように思うけど、その関係性はどこにあるのか。我思う、故に我在り(Je pense, donc je suis)とは、フランス生まれの哲学者であり、数学者であり合理主義哲学の祖であるルネ・デカルト(René Descartes、1596年3月から1650年2月)がデカルトの著書「方法序説」で説いた命題だ。今、受講している脳型情報処理機械論も、脳科学のアプローチと言える。脳の仕組みを理解し、活用することで人工知能のさらなる飛躍に繋げたいという想いがある。しかし、その心はいったいどこにあるのだろう。東北福祉大学の小川誠ニ特任教授は機能的磁気共鳴映像(fRMI)の原理に基づいて脳の活動を映像化する装置が開発され、脳内の各部分の活動と行動や心の動きを対応させることができた。しかし、それで脳と心の関係を知ることであり、心を知ることではない。感情を持つ人工知能を開発する動きもある。高知大学の塩原俊彦准教授は、「AIが感情と意識を持つことは可能か」という研究を進めている。動物には心や感情がある。逆説的だけど、感情や心をもつ人工物が出現するのだろうか?それとも人類の知性を広げるためのツールとして人工知能は発達するのだろうか。講義の内容からどんどんずれていくので、この辺りで妄想は終わりにして、キーワードを紐解いていきたい。

(出典:ICHI.PRO)

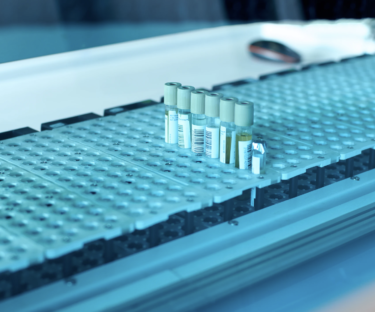

生体外培養神経回路の自由エネルギー原理

下の図は、磯村博士の論文「自由エネルギー原理の解説」に掲載されていた図で、外界の生成過程(左)と脳内のニューラルネット(右)だ。論文の中で、「自由エネルギー原理では異なるグループの神経活動が隠れ変数uの事後期待値及び予測誤差をコードし、シナプス結合協働が生成モデルのパラメータθをコード化する。感覚入力のサプライズを最小化するように神経活動を変化させることを推論と呼び、シナプス結合を変化させることを学習という。」と説明していた。なお、インビトロ(in vitro)は、生体外培養の意味で、ガラスの中(試験管内)が語源だ。生物学の実験などにおいて、試験管内などの人工的に構成された条件下であることを意味する用語だ。一方、生体由来ではなくシミュレーションしたものは「in silco」であり、生体外ではなく生体内だと「in vivo」だとなる。

(出典:解説論文)

KL距離

KL距離とは、カルバック・ライブラー情報量(Kullback–Leibler divergence)の略だ。確率論と情報理論における2つの確率分布の差異を計る尺度である。相対的なエントロピー(relative entropy)と呼ばれ、情報のばらつきとは対照的に、分布的に非対称な指標であるため、統計的な広がりの指標としては適格ではなく、三角不等式も満たさないため、数学的な意味での距離ではない。下の図は、2つの確率分布のヒストグラムを書いて、そのKL距離を表示したものだ。図(左)はピンクとグリーンが乖離が大きいが、図(中)ではその乖離が少なく、図(右)ではピッタリと合致し、KL距離がゼロとなっている。この概念は1951年にソロモン・カルバックとリチャード・ライブラーが用いたものであり、ベクトル解析におけるダイバージェンスとは異なる概念である。この尺度は、驚きの尺度であり、応用統計学、流体力学、神経科学などの分野で応用されている。

(出典:自由エネルギー原理の基礎について徹底解説)

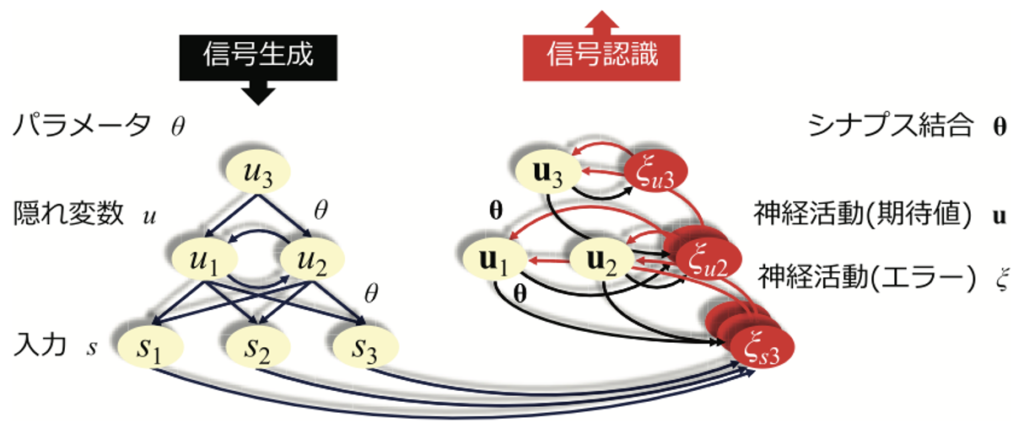

勾配降下法(Minimising cost functions)

勾配降下法とは、コストを最小化する方法だ。たとえば、山頂から下山する場合に、どのようなルートで下山するのがベストなのかを解決するのが勾配降下法であり、コスト関数のローカルまたはグローバルな最小値を見つけようとする効率的な最適化アルゴリズムである。下の図(左)のように曲線が凸型(Convex)の場合は最適値は明確だ。下の図(右)のように凸型ではない場合にはローカル解とグローバル解を間違えないようにする必要がある。また、確率的勾配降下法の場合には、SGD(Stochastic gradient descent)と呼ぶ。適切な平滑性を持つ目的関数を最適化する反復法であり、実際の勾配をその推定値で置き換えるため、勾配降下法の確率的な近似とみなすことができる。特に高次元の最適化問題では、計算負荷が軽減され、収束率の低下と引き換えに、より高速な反復処理が可能になる。確率的近似の基本的な考え方は、1950年代のRobbins-Monroアルゴリズムにまで遡る。米国の数学者・統計学者であるハーバート・エリス・ロビンズ(Herbert Ellis Robbins、1915年1月から2001年2月)と、米国学術行政官であり、ハーバード大学の学部長(1958-1967年)を務めたジョン・アッシャー・モンローが提唱した最適化手法だ。

(出典:towards data science)

二次曲線速度向上定理(Quadratic Speedups Theorem)

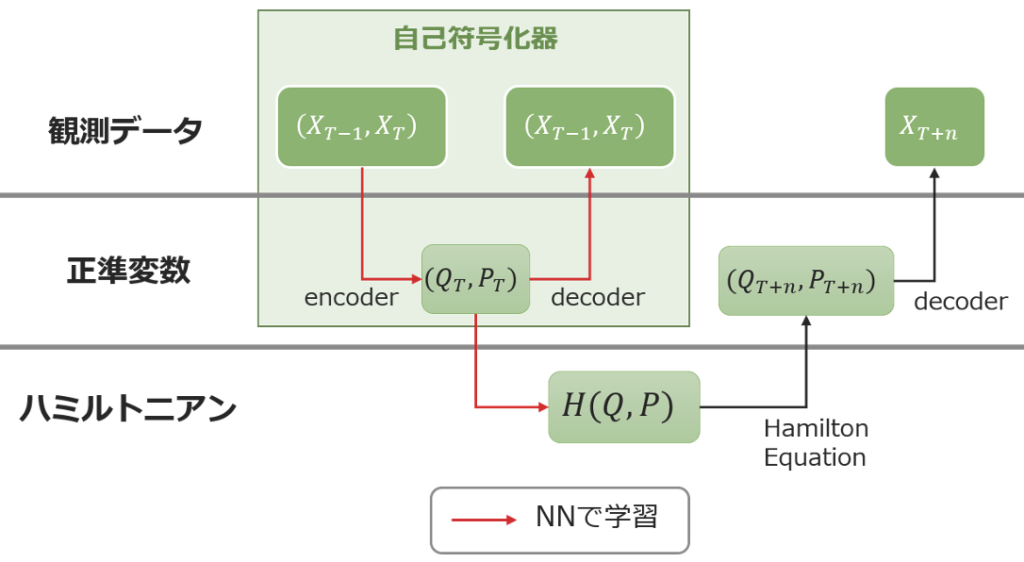

Quadraticとは二次関数の意味だ。二次関数とはy=x^2のように次数が2の多項式で表現される関数だ。これまでのコンピューターは二次関数的な速度で性能が改善されてきた。しかし、現在世界中だ開発競争が激化している量子コンピューティングが劇的な進化が図られる可能性がある。IBMやGoogleの研究者の予測を信じるならば,今後5年以内に,数千個の物理的量子ビットを備えた小規模なフォールト・トレラント量子コンピュータを利用できるようになるかもしれない。テクノロジー業界に革命を起こすような量子コンピュータの登場が期待される。なお、下の図のハミルトニアンとは、ハミルトン力学であり、一般化座標と一般化運動量を基本変数として記述された古典力学である。これがニューラルネットワーク(NN)での記述に活用されている。ダブリン生まれのイギリスの数学者・物理学者ウィリアム・ローワン・ハミルトン(William Rowan Hamilton、1805年8月から1865年9月)が創始した記述法だ。ラグランジュ力学と同様にニュートン力学を再定式化した解析力学の一つの定式化と言える。

(出典:Albert Official Blog)

創発の定理(Emergence theorem)

これも全く意味を理解できなかった。調べると日本語では創発の定理と呼ぶようだ。空間と時間の構造を一次元のひもやエネルギーでできているのではなく、幾何学的な投影から作られたコードや言語にすぎないという考えに基づいている。下の図に示すように意識から物理学が創発され、理論的基盤が創発され、汎意識基盤が創発され、意識のネットワークから生物の意識への創発されるという図式だ。

(出典:Towards Life-knowledge)

米国ロサンゼルスに拠点を置く数学者と物理学者のチーム「Quantum Gravity Research」は創発理論(Emergence theorem)と呼ぶ量子重力理論の理論的枠組みの開発に取り組んでいる。相対性理論、量子力学、意識の理論を数学的、科学的に統一しようとするものだ。哲学的な話が中心だが、この創発理論を物理の統一理論へと完成させるための次の7つの手がかりを挙げている。

1.Information(情報)

2.Causality loops(因果ループ)

3.Non determinism(非決定論)

4.Consciousness(意識)

5.Pixelation(ピクセル化)

6.E8 Crystal(8次元のクリスタル)

7.Golden Ratio(黄金比)

(出典:創発理論)

まとめ

脳科学の最先端の知識や理論がぎっしり詰まった講義だった。ネットで調べて裏の取れたものもあれば、全くヒットしないものもあった。今回は、ネットで確認が取れて自分なりに理解できたことをまとめたので、講義の内容とは全く別物になってしまった。ただ、このような話題を含めて、最先端の研究分野を垣間見れたのは非常に嬉しい。独学では決して考えることができない世界だったと思う。こういう理論の世界は大好きだけど、エンジニアとしては、これらの知見をベースに何を作るのかを考える必要があるのかもしれない。個人的には脳波を活用して社会的な課題を解決するような仕組みを作り出せないものかとない頭を捻っている(笑)。

以上

最後まで読んで頂きありがとうございました。

拝